Ông nhận định thế nào về việc tin tặc đang có xu hướng "vũ trang hóa" AI để thực hiện các cuộc tấn công và lừa đảo trên mạng?

TS Nguyễn Tuấn Khang: Theo Báo cáo chỉ số nguy cơ an ninh mạng (X-Force Threat Intelligency Index) năm 2024 của IBM, châu Á – Thái Bình Dương, bao gồm cả Việt Nam là khu vực hứng chịu các cuộc tấn công mạng nhiều top 3 thế giới năm 2023. Trong đó, sản xuất là ngành chịu tác động nhiều nhất bởi các sự cố tấn công mạng.

Thủ đoạn chính của kẻ xấu vẫn là tấn công phishing (lừa đảo) nhằm vào các đối tượng yếu thế và khai thác lỗ hổng để cài cắm mã độc. Bên cạnh đó, xu hướng mới nổi năm 2024 là các vụ tấn công mạng có sự tham gia của trí tuệ nhân tạo (AI).

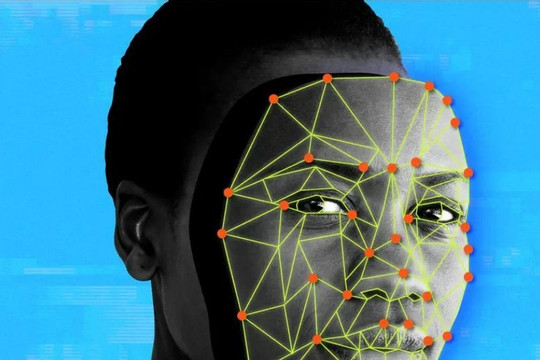

Báo cáo của Wired chỉ ra rằng, nhiều kẻ xấu đang sử dụng AI tạo sinh để giúp hướng dẫn thực hiện các vụ hack, tạo các con chatbot lừa đảo hoặc những hình ảnh, video giả mạo khuôn mặt, giọng nói người khác bằng Deepfake.

Tuy nhiên, cùng với xu hướng này, các hệ thống an toàn thông tin cũng bắt đầu được tích hợp tính năng AI, ví dụ như watsonx. Trí tuệ nhân tạo có thể bị lợi dụng, nhưng cũng có thể thay thế con người trong việc phân tích, giám sát, định danh số, dự đoán các kịch bản tấn công, từ đó nâng cao năng lực phòng thủ, giảm thiểu rủi ro về an toàn thông tin.

Ngày càng xuất hiện nhiều các vụ lừa đảo bằng Deepfake. Với sự phát triển nhanh của AI, các vụ tấn công này sẽ nguy hiểm đến mức nào trong tương lai?

TS Nguyễn Tuấn Khang: Về cơ bản, Deepfake là công nghệ giúp hacker có thể tạo nên định danh số giả, từ đó giả mạo người khác. Deepfake sẽ là một vấn nạn nguy hiểm bởi công nghệ này đang ngày càng trở nên tinh vi hơn.

Để chống lại Deepfake, việc đầu tiên cần làm là phải xác định hình ảnh, giọng nói của một người nào đó có phải do AI tạo ra hay không. Hiện không có công cụ vạn năng giúp phát hiện Deepfake ngay lập tức bởi kẻ tấn công liên tục phát triển ra các mô hình mới.

Ngoài việc nhận biết Deepfake, còn một kỹ thuật khác để đối phó, đó là dùng công nghệ để phân tích hành vi. Ở góc độ tổ chức, doanh nghiệp, cần phát triển hệ thống có sự kết hợp của cả hai kỹ thuật này.

Thời gian qua, đã có những cuộc tấn công mạng mà hacker âm thầm nuôi mã độc trong hệ thống của doanh nghiệp. Mã độc nằm chờ ở đó và phân tích toàn bộ hoạt động, từ đó tạo ra một danh tính giả để thực hiện ý đồ xấu. Với sự phát triển của công nghệ Deepfake, cộng với khả năng tạo video của AI tạo sinh, những vụ tấn công kiểu này sẽ còn nguy hiểm hơn nhiều trong tương lai.

Trước sự leo thang của tấn công mạng bằng Deepfake, làm sao để bảo vệ người già, trẻ em và các đối tượng yếu thế khác khỏi những kẻ lừa đảo?

TS Nguyễn Tuấn Khang: Người già và trẻ em thường bị những kẻ lừa đảo tấn công bằng một kỹ thuật được gọi là social engineering (tấn công phi kỹ thuật). Đây là thuật ngữ mô tả việc tấn công thông qua hình thức thao túng hành vi của con người.

Hacker hiện có thể dùng AI kết hợp với việc thu thập, khai thác, phân tích dữ liệu, từ đó xác định những người có khả năng bị lừa cao rồi tìm cách tấn công. Ngoài việc nâng cao nhận thức cho cộng đồng, chúng ta cũng phải chấp nhận việc sẽ xảy ra tình huống người dùng bị lừa, và phải sử dụng công nghệ để phát hiện, ngăn chặn điều đó.

Thời gian gần đây có vụ việc một nhân viên ngân hàng nghi ngờ cụ bà đến giao dịch chuyển tiền có dấu hiệu bị lừa đảo. Người này sau đó đã ngăn chặn kịp thời và báo với lực lượng chức năng. Hệ thống IT của các ngân hàng giờ đây phải có công nghệ để làm thay con người trong những việc như vậy.

Vai trò của công nghệ là dù biết người chuyển tiền chính chủ, hệ thống vẫn tiến hành ngăn chặn nếu nghi ngờ hành vi này bị người khác thao túng. Những công cụ như vậy được gọi là hệ thống hạn chế gian lận, giả mạo.

Liệu đã đến lúc Việt Nam nên có chế tài để quản lý AI, đưa việc nghiên cứu, phát triển, sử dụng AI vào khuôn khổ?

TS Nguyễn Tuấn Khang: Chế tài quản lý AI là vấn đề đã được nhắc đến từ lâu, tuy nhiên, vẫn còn nhiều điều gây tranh cãi. Lấy một ví dụ, bãi xe khu tôi ở có hệ thống AI nhận diện biển số xe, thế nhưng vẫn có vụ mất cắp xảy ra. Khi ấy, mới bắt đầu nảy sinh tranh cãi về việc lỗi tại ai. Chủ chung cư, người bảo vệ hay đơn vị phát triển hệ thống AI phải chịu trách nhiệm?

Từ đấy trở đi, tòa nhà đã thay đổi nội quy, trong đó ghi rõ cư dân có thể chọn dùng AI nhận biết biển số xe để tiện lợi hơn, nhưng họ phải chấp nhận rủi ro. Người nào đồng ý thì sẽ được dùng cửa tự động, người nào không chấp nhận thì gửi xe theo cách cũ. Chúng ta phải có chế tài kiểu như vậy.

Tương tự, IBM từng phát triển một hệ thống AI giúp phòng chống ung thư. Khi hệ thống đưa ra đơn thuốc, người bệnh uống xong vẫn không cứu được thì lỗi tại bác sĩ hay trí tuệ nhân tạo?

Tôi nghĩ chế tài cho AI cần được quy định cụ thể, nói rõ những việc được làm và không được làm khi phát triển ứng dụng AI. Để thế giới an toàn hơn, những chế tài cơ bản nhất mà chúng ta có thể làm là buộc các giao dịch chuyển tiền lớn cần phải nhận biết bằng sinh trắc học. Trong tình huống như vậy, những người bị mất thông tin danh tính hoàn toàn có thể tránh được việc bị mất tiền.

Cảm ơn ông.