Tội phạm mạng sử dụng AI, deepfake nâng cấp các cuộc tấn công

Deepfake là công nghệ được sử dụng để tạo ra nội dung giả mạo, đặc biệt là video, trong đó khuôn mặt hoặc âm thanh của một người sẽ được ghép vào các video, âm thanh của người khác.

Trong nội dung tổng hợp các hình thức lừa đảo phổ biến trên không gian mạng Việt Nam 2 tuần trước và trong đợt nghỉ Tết Nguyên đán Giáp Thìn 2024, Cục An toàn thông tin (Bộ TT&TT) đã tiếp tục có cảnh báo về thủ đoạn sử dụng trí tuệ nhân tạo để giả mạo hình ảnh và giọng nói nhằm lừa đảo chiếm đoạt tài sản của người dân.

Theo đó, nhiều người dân Việt Nam đã trở thành nạn nhân của các cuộc lừa đảo tài chính sử dụng deepfake. Cụ thể, đối tượng lừa đảo sử dụng AI để tạo sẵn đoạn video giả mạo gương mặt và giọng nói của chủ tài khoản Facebook; khi được yêu cầu gọi video call để chứng thực, đối tượng nhận cuộc gọi và phát đoạn video giả mạo hòng lừa người dùng.

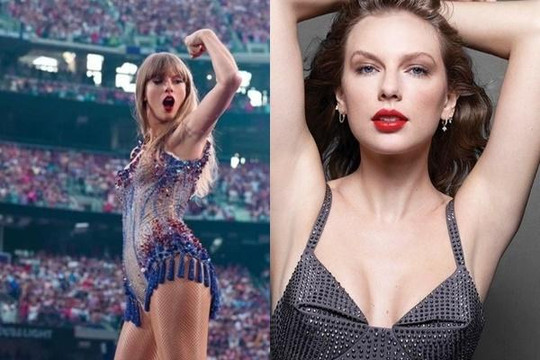

Không chỉ tại Việt Nam, trên thế giới cũng đã ghi nhận nhiều vụ sử dụng deepfake để giả mạo hình ảnh của các nhân vật nổi tiếng như video deepfake vợ chồng Tổng thống Singapore hồi cuối năm ngoái hay ảnh deepfake khiêu dâm của nữ ca sĩ Taylor Swift lan truyền trên X và Facebook vào tháng 1/2024.

Trao đổi với phóng viên VietNamNet, các chuyên gia đều dự báo năm 2024 sự phát triển mạnh mẽ của công nghệ trí tuệ nhân tạo - AI sẽ tiếp tục đưa đến những công cụ phục vụ mục đích xấu như lừa đảo, tấn công mạng.

Theo Giám đốc kỹ thuật Công ty NCS, AI tạo sinh như ChatGPT và deepfake sẽ được các đối tượng xấu sử dụng để tự soạn những kịch bản lừa đảo nhằm chiếm đoạt tiền của nạn nhân. Cùng với đó, mã độc và các công cụ khai thác lỗ hổng sẽ được trang bị thêm trí tuệ nhân tạo để tăng khả năng khai thác lỗ hổng cũng như giúp qua mặt các giải pháp an ninh mạng.

Đồng quan điểm, chuyên gia VSEC cho rằng một trong những xu hướng tấn công mạng nổi bật trên không gian mạng Việt Nam năm 2024 là việc những kẻ tấn công sử dụng những công nghệ mới AI, machine learning và deepfake để nâng cấp các cuộc tấn công của mình một cách tinh vi hơn.

“2024 là năm sẽ xuất hiện nhiều cuộc tấn công có kịch bản được hỗ trợ bởi AI, đặc biệt là những cuộc tấn công lừa đảo qua video call sử dụng deepfake”, chuyên gia VSEC nêu quan điểm.

Cách phát hiện, ngăn chặn hình ảnh giả mạo do deepfake

Thảo luận về ảnh hưởng, tác động từ việc gia tăng sử dụng công nghệ mới như AI, Tiến sĩ Jonathan Crellin, Chủ nhiệm bộ môn An toàn thông tin thuộc khoa Khoa học, kỹ thuật và công nghệ của Đại học RMIT cho rằng tội phạm mạng đang khai thác công nghệ mới theo những cách ‘không lường trước được”.

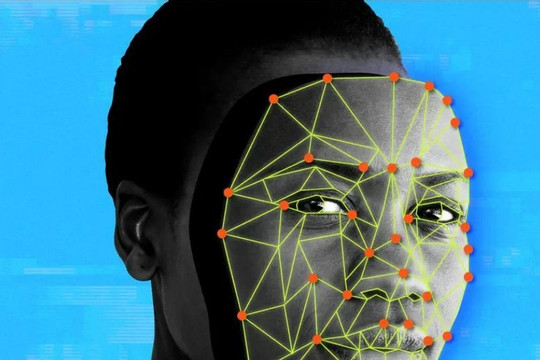

Cũng theo Tiến sĩ Jonathan Crellin, bất cứ ai cũng có thể trở thành nạn nhân của deepfake, khi đối tượng xấu chỉ cần hình ảnh, video hoặc bản ghi âm của người bị giả mạo. Giả mạo dưới nhiều hình thức khác nhau có khả năng được dùng để tạo ra những tin tức sai lệch.

Đưa ra gợi ý về một số cách để phát hiện và ngăn chặn hình ảnh giả mạo do deepfake, vị chuyên gia này cho rằng, việc đầu tiên người dùng cần làm là giảm số lượng hình ảnh, video hoặc bản ghi âm trực tuyến: “Hãy đảm bảo rằng bạn chỉ chia sẻ chúng với người quen chứ không đăng tải rộng rãi trên mạng. Một khi đã đưa nội dung lên Internet thì hầu như không thể xóa bỏ”.

Cùng với đó, điều người dùng có thể áp dụng là đảm bảo quy ước 1 từ bí mật với gia đình để xác thực cuộc gọi, từ đó giúp giảm bớt nguy cơ rơi vào bẫy của cuộc gọi giả mạo. Ngoài ra, các hình ảnh, đặc biệt là video tạo ra từ deepfake có thể có các lỗi kỳ lạ trông như được dàn dựng, vì thế khi người dùng nhận thấy những lỗi này thì khả năng cao là hình ảnh, video đã bị làm giả.

Bên cạnh đề xuất việc sử dụng kỹ thuật tìm kiếm “hình ảnh đảo chiều” từ Google hoặc các công cụ tìm kiếm khác để xác định nguồn của ảnh gốc, Tiến sĩ Jonathan Crellin cũng khuyến nghị mọi người đừng mù quáng tin ngay vào những gì nhìn thấy, bởi máy ảnh (hoặc AI) có thể nói dối.

Người nổi tiếng ứng phó mối nguy từ deepfake thế nào?

Xem xét tác động của deepfake từ một góc nhìn khác, Tiến sĩ Nguyễn Văn Thăng Long, giảng viên cấp cao Khoa Truyền thông và thiết kế (Đại học RMIT) nhận định: “Deepfake tạo ra mối nguy lớn cho người nổi tiếng và chính trị gia, do thông tin tiêu cực về họ xuất hiện với tần suất liên tục khiến công chúng có cái nhìn không thiện cảm với họ”.

Từ nhận định trên, Tiến sĩ Nguyễn Văn Thăng Long khuyến cáo, với sự tràn lan của tin giả từ deepfake, đội ngũ truyền thông của người nổi tiếng, chính trị gia cần có sẵn nguồn lực để theo dõi và phản ứng kịp thời với tin giả hay liên tục hiệu đính các tin tức sai lệch.

Trong bối cảnh deepfake lan tràn, chiến lược quản lý rủi ro hiệu quả vẫn là duy trì các kênh thông tin nhất quán, thông qua các nền tảng mạng xã hội phổ biến, website, hay gặp mặt trực tiếp, giữa doanh nghiệp, người nổi tiếng, chính trị gia với các bên có liên quan chính như người hâm mộ, báo chí, cộng đồng, nhân viên.

“Bằng cách duy trì các kênh truyền thông này, việc tiếp nhận nhanh chóng thông tin liên quan đến deepfake sẽ khả thi hơn, giúp việc hiệu đính tin đồn được kịp thời và hiệu quả, đồng thời vạch trần thông tin sai lệch ngay từ đầu”, chuyên gia Đại học RMIT phân tích.

Ngoài ra, các công ty, người nổi tiếng, chính trị gia cần lên trước kịch bản xử lý khủng hoảng dành riêng cho deepfake. Với kế hoạch bài bản được chuẩn bị tốt, việc xử lý khủng hoảng do deepfake sẽ trở nên khả thi hơn, giảm thiểu các hậu quả đáng tiếc có thể xảy ra.