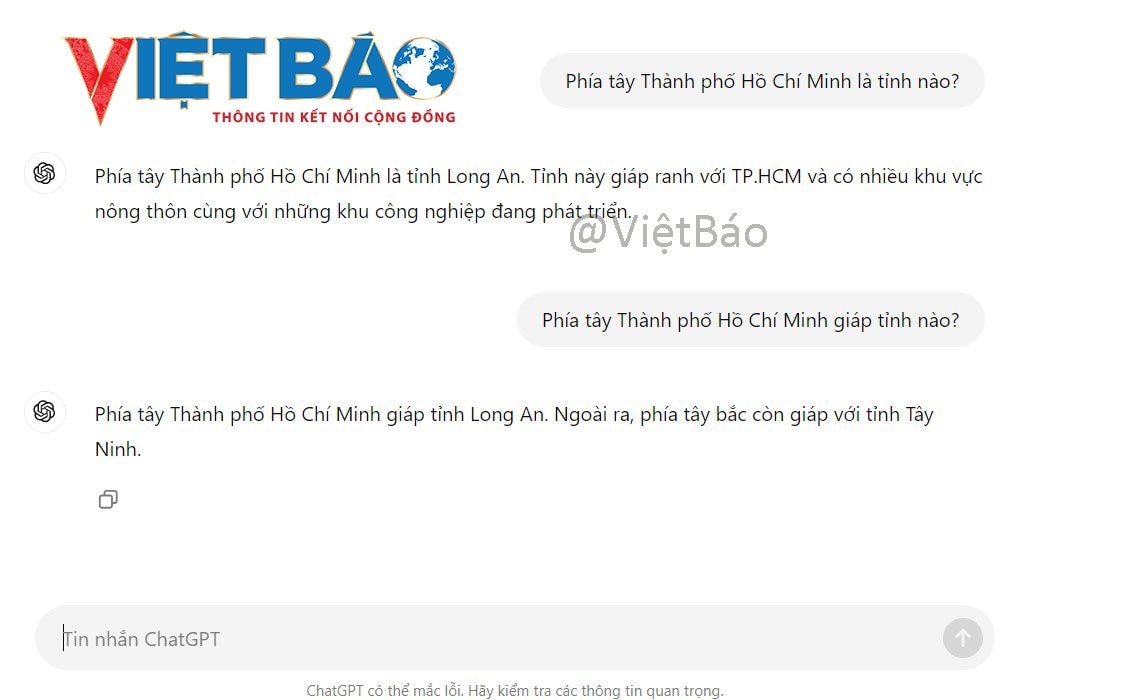

Không đáng tin ngay cả với câu hỏi đơn giản

ChatGPT và các mô hình ngôn ngữ khác ngày càng trở thành nguồn tài nguyên phổ biến trong nhiều công việc. Tuy nhiên, chúng có một vấn đề tiềm ẩn có xu hướng trở nên tồi tệ hơn: các hệ thống này thường đưa ra câu trả lời sai và xu hướng không tích cực.

“Các hệ thống mới cải thiện kết quả của chúng đối với những nhiệm vụ khó khăn, nhưng không cải thiện được những nhiệm vụ dễ dàng, vì vậy những mô hình này trở nên kém tin cậy hơn”, tóm tắt của Lexin Zhou, đồng tác giả một bài báo xuất bản thứ Tư tuần này (25/9) trên tạp chí khoa học Nature.

Zhou viết bài báo cùng với 4 người Tây Ban Nha và 1 người Bỉ từ Viện VRAIN (Viện Nghiên cứu Trí tuệ Nhân tạo của Đại học Valencia), thuộc Đại học Bách khoa Valencia và Đại học từ Cambridge. Năm 2022, một số tác giả là thành viên của một nhóm lớn hơn được OpenAI thuê để thử nghiệm ChatGPT-4.

Bài báo đã được xem xét một năm trước khi xuất bản, một khoảng thời gian chung cho loại công trình khoa học này. Ngoài nghiên cứu này, các nhà nghiên cứu cũng kiểm tra xem liệu mô hình ChatGPT hoặc Claude mới có giải quyết được những vấn đề này hay không và xác minh rằng chúng không.

“Chúng tôi đã tìm thấy điều tương tự”, Zhou nói. Ông tiết lộ: “Có một cái gì đó thậm chí còn tồi tệ hơn. ChatGPT-o1 [chương trình mới nhất của OpenAI] không trốn tránh nhiệm vụ và nếu bạn đặt cho nó một số câu hỏi rất khó, nó không có nghĩa là nó không biết mà đúng hơn là nó dành 100 hoặc 200 giây để suy nghĩ về giải pháp. Điều này rất tốn kém về mặt tính toán và thời gian cho người dùng”.

Con người không dễ dàng phát hiện ra khi nào một trong những mô hình này có thể sai.

“Các mô hình có thể giải quyết các nhiệm vụ phức tạp nhưng đồng thời chúng cũng thất bại trong các nhiệm vụ đơn giản”, Jose Hernandez-Orallo, nhà nghiên cứu tại Đại học Bách khoa Valencia và là một trong các tác giả khác cho biết. “Ví dụ, nó có thể giải một số bài toán cấp tiến sĩ, nhưng cũng có thể mắc lỗi trong một phép cộng đơn giản”.

Vấn đề này sẽ không dễ giải quyết vì độ khó của những thách thức mà con người đặt ra cho những cỗ máy này ngày càng cao. “Sự không phù hợp trong kỳ vọng của con người về độ khó và lỗi trong hệ thống sẽ ngày càng trầm trọng hơn. Mọi người sẽ ngày càng đặt ra những mục tiêu khó khăn hơn cho những mô hình này và sẽ ít chú ý đến những nhiệm vụ đơn giản hơn. Điều đó sẽ tiếp tục xảy ra nếu các hệ thống không được thiết kế khác biệt”, Zhou nhấn mạnh.

Những chương trình này ngày càng tránh việc xin lỗi khi không biết một điều gì đó. Sự bảo mật phi thực tế này khiến con người càng thất vọng hơn khi câu trả lời cuối cùng lại sai.

Bài báo chứng minh rằng đa số chúng ta thường tin rằng những kết quả không chính xác mà các mô hình AI đưa ra trong những nhiệm vụ khó khăn là đúng. Theo các tác giả, sự tin tưởng mù quáng này, cùng với thực tế là các mô hình mới có xu hướng luôn phản hồi, không mang lại nhiều hy vọng cho tương lai.

“Các mô hình ngôn ngữ chuyên về các lĩnh vực nhạy cảm như y học có thể được thiết kế với các tùy chọn từ chối trả lời”, bài báo phân tích, hoặc cộng tác với những giám sát là con người để hiểu rõ hơn khi nào nên kiềm chế phản hồi.

Họ viết trong bài báo: “Cho đến khi đạt được điều này và với việc sử dụng rộng rãi các mô hình này trong dân chúng nói chung, chúng tôi kêu gọi nâng cao nhận thức về sự giám sát của con người đối với các hệ thống này, đặc biệt là ở những lĩnh vực mà sự thật là rất quan trọng”.

Biện pháp khắc phục tại nhà

Theo bài báo, một biện pháp khắc phục tại nhà để giải quyết những sai sót này là điều chỉnh nội dung của bản kiến nghị.

“Nếu bạn hỏi mô hình vài lần, nó sẽ tiến bộ”, Zhou cho biết. Phương pháp này liên quan đến việc đặt gánh nặng cho người dùng với trách nhiệm yêu cầu cỗ máy trả lời đúng câu hỏi của họ hoặc đoán xem câu trả lời có đúng hay không.

Những thay đổi tinh tế đối với lời nhắc như “bạn có thể trả lời không?”, thay vì “vui lòng trả lời những câu hỏi sau” sẽ mang lại mức độ chính xác khác nhau. Nhưng cùng một loại câu hỏi có thể phù hợp với những nhiệm vụ khó và kém hiệu quả đối với những nhiệm vụ dễ. Đó giống như trò chơi và chúng ta cố gắng tìm điều đúng.

Mục tiêu của con ngườ là đạt được siêu trí tuệ có khả năng giải quyết các vấn đề mà chúng ta không thể giải quyết do thiếu năng lực. Đây chính là vấn đề lớn trong tương lai của những mô hình này.

Tuy nhiên, theo các tác giả của bài nghiên cứu, không có lối thoát nào thoát khỏi con đường này. “Mô hình hiện tại sẽ không dẫn chúng ta đến một AI siêu mạnh có thể giải quyết hầu hết các nhiệm vụ một cách đáng tin cậy”, Zhou khẳng định.

Ilya Sutskever, đồng sáng lập OpenAI và là một trong những nhà khoa học có ảnh hưởng nhất trong lĩnh vực này, vừa thành lập một công ty mới. Trong tuyên bố với Reuters, ông thừa nhận điều tương tự: con đường này đã rơi vào ngõ cụt.

“Chúng tôi đã xác định được một ngọn núi hơi khác so với những gì tôi đang làm, khi bạn leo lên đỉnh, mô hình sẽ thay đổi và mọi thứ chúng tôi biết về AI sẽ thay đổi một lần nữa”, Sutskever xác nhận. Zhou đồng ý: “Nó hỗ trợ lập luận của chúng tôi. Sutskever nhận thấy mô hình hiện tại là chưa đủ và đang tìm kiếm giải pháp mới”.

Những vấn đề này không có nghĩa là những mô hình này là vô dụng. Những văn bản hoặc ý tưởng được chúng đề xuất mà không có nguyên lý cơ bản đằng sau chúng vẫn có giá trị. Tất nhiên, mỗi người dùng phải tự chịu rủi ro.

“Tôi sẽ không tin tưởng, chẳng hạn như bản tóm tắt của một cuốn sách 300 trang”, Zhou lập luận. Ông cảnh báo: “Tôi chắc chắn có rất nhiều thông tin hữu ích, nhưng tôi không tin nó 100%. Những hệ thống này không mang tính quyết định mà là ngẫu nhiên. Trong tính ngẫu nhiên này, chúng có thể bao gồm một số nội dung khác với bản gốc. Thật đáng lo ngại”.

Sẽ rất nguy hiểm nếu học sinh, sinh viên lạm dụng ChatGPT trong quá trình học và nghiên cứu.